Aufgabe:

Im Rahmen einer Programmieraufgabe muss ich mich mal wieder mit mathematischen Verfahren auseinander setzen. Kleinere Schritte konnte ich bereits bewältigen, doch für das weitere Vorgehen fehlt mir gerade der Ansatz. Es geht um ein Zeigermessgerät, wo ich den Grad des Zeigers berechnen soll. Um es zu verstehen widmete ich mich erstmal der Theorie.

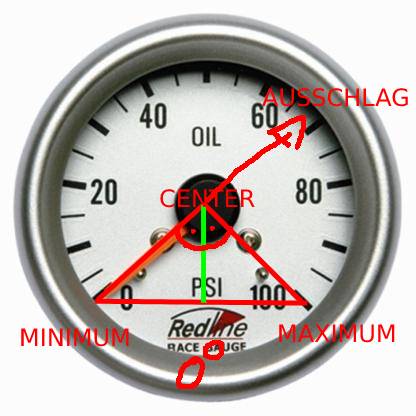

Als erstes würde ich gerne den Bereich unten ausrechnen um den Grad von 360 Grad abziehen zu können, damit ich nur noch den Grad zwischen Minimum und Maximum habe. Den zu gezeichneten Ausschlag kann man hier ignorieren.

Problem/Ansatz:

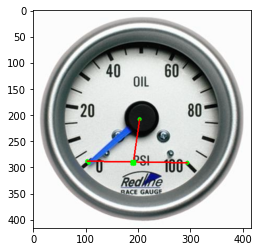

Nun habe ich bereits Beispiels Koordinaten (X|Y) für Min, Max, Center und den Pointer. Mithilfe einer Geradengleichung habe ich dann den unteren Punkt der grünen Linie berechnen können. Anhand des folgenden Bildes sieht man über welche X|Y Koordinaten ich aktuell verfüge.

Nun bin ich mir aber unsicher, wie ich die im obigen Bild gekennzeichneten Winkel mithilfe dessen was ich bereits habe berechnen könnte.

Das hier wären meine Beispielskoordinaten, welche oben als grüne Punkte eingezeichnet sind.

minPoint = [103,288]

maxPoint = [294,291]

centerPoint = [203, 208]

pointerPoint = [106,291]

hilfsLinie = [191|291] ist der Grüne Punkt zwischen Minimum und maximum

Ich würde mich freuen, wenn mir jemand ein wenig aushelfen könnte

Viele Grüße