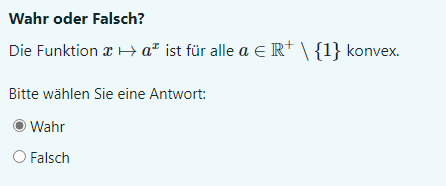

Ansatz : f(x) = a^x

f´(x) = a^x*ln(a)

f´´(x) = a^x*ln(a)^2

Da ln(a)^2 > 0 und a^(x) > o ist muss f´´(x) > 0 sein, weil a∈ℝ+ ist. Für konvexe Funktion muss f´´(x) > 0 sein.

Deshalb ist die Aussage wahr.

Sind meine Überlegungen richtig ?

Vielen Dank im Voraus